Адрес для входа в РФ: exler.wiki

Вчера в комментариях к записи "Испания осталась без газа" обсуждали использование солнечной энергии. И мне на почту прислали статью руководителя компании "Битрикс" Сергея Рыжикова (я с ним лично знаком) "Солнечная электростанция на западе России", в которой он рассказывает о своем опыте установки электростанции в частном доме в городе Калининграде.

Вступление в статье такое.

Сегодня исполняется год как я сделал солнечную электростанцию, научился обеспечивать себя электричеством и даже научился отдавать излишки в городскую электросеть, и официально крутить счетчик в обратную сторону. Поговаривают, что я первый в стране частный дом, который делится излишками энергии с соседями.

Ну и далее в статье Сергей расписывает все этапы создания солнечной энергоустановки в его дома. Почитать было очень интересно.

Также, конечно, очень интересовали прикидки Сергея по поводу рентабельности подобной установки. Там выводы следующие.

Меня неоднократно спрашивали, окупится ли когда-то мой проект или нет. Я думаю, что именно мой проект полностью не окупится никогда. Он сделан не для экономии. Ну и я местами сильно перезаложился от нехватки опыта. Хотя, по старому курсу покупки и в условиях подключения к городу, у него есть шанс окупиться за 10 лет.

Солнечные батареи рассчитаны на десятилетия. Потеря эффективности с возрастом незначительная. Надо только не забывать их протират, я делаю это раз в год. На все оборудование гарантия так же лет десять. Аккумуляторы я научился экономно использовать благодаря подключению к городу.

Я уверен, что можно сделать экономически рентабельное подключение, особенно если скидывать энергию в город. Панели и инвертор, вот и все что нужно. 5-7 лет будет вполне достижимый цикл окупаемости.

Возможно в будущем появятся более эффективные солнечные пластины или более надежные аккумуляторы. Я так же уверен, что появятся готовые наборы для перевода дома на солнечную энергетику и можно будет осуществить такой проект и значительно дешевле и значительно быстрее.

Источник (англ.)

Исследователи из Калифорнийского технологического института создали двуногого робота, который сочетает ходьбу с полетом, что делает его исключительно проворным и способным к сложным движениям.

Назвали его LEONARDO (сокращенно от «LEgs ONboARD drOne» или сокращенно LEO) может ходить по натянутой веревке, прыгать и даже кататься на скейтборде. Разработанный командой Центра автономных систем и технологий (CAST) Калифорнийского технологического института, LEO является первым роботом, который использует многосуставные опоры и двигатели на основе пропеллера для достижения точной степени контроля над балансом.

«Мы черпали вдохновение в природе. Подумайте о том, как птицы могут хлопать крыльями и прыгать, чтобы перемещаться по телефонным линиям», - говорит Сун-Джо Чанг, автор-корреспондент и профессор Брена по аэрокосмическим и динамическим системам. «Птицы умеют совмещать ходьбу с полетом, этим мы и вдохновлялись при создании нашего робота».

Ну и, в общем, создатели намерены и дальше совершенствовать этого робота, потому что на данный момент энергия у него используется не слишком эффективно.

Но он уже производит впечатление, посмотрите ролик.

Зацените Тома Круза.

@deeptomcruise Sports!

♬ original sound - Tom

@deeptomcruise ♬ original sound - Tom

@deeptomcruise I love magic!

♬ original sound - Tom

Так вот, это не Том Круз. Это аккаунт Deeptomcruise, то есть работает технология DeepFake. При этом уже настолько качественная, что подделку не смогли распознать даже специальные алгоритмы, направленные на выявление фейков.

Я читал, что это аккаунт Майлза Фишера - имитатора Тома Круза: Майлз на него сильно похож. А сами дипфейки - работы специалиста по визуальным эффектам Криса Юме.

В общем, похоже, что сейчас фейк от реальности отличить уже почти невозможно: на роликах выше не видно никаких следов наложения даже во всяких сложных сценах (обычно все-таки DeepFake можно было отличить).

И не только глюкометре. Речь идет об датчике, способном измерять такие параметры, как внутренняя температура тела, артериальное давление, гидратация тела, уровни алкоголя, лактата и глюкозы. Так, по крайней мере, заявляет производитель.

Кратко.

Компания Rockley Photonics, ведущая мировая компания в области кремниевой фотоники, представила полную комплексную цифровую сенсорную систему "клиника на запястье".

Сенсорный модуль Rockley позволят носимым устройствам отслеживать несколько биомаркеров, включая внутреннюю температуру тела, артериальное давление, гидратацию тела, тенденции алкоголя, лактата и глюкозы, среди прочего.

Полнофункциональное сенсорное решение Rockley включает браслет, который содержит модуль датчика и взаимодействует с настраиваемыми облачными аналитическими механизмами через приложение для смартфонов Rockley. В ближайшие месяцы браслет будет использоваться в обследованиях людей.

Центральным элементом сенсорной системы является неинвазивный сенсорный модуль, основанный на спектроскопической технологии платформы Rockley. В отличие от более распространенных решений для спектроскопии, в которых используются источники света с широким спектром, сенсорный модуль Rockley генерирует большое количество дискретных выходных сигналов лазера от одного кремниевого чипа, охватывающего широкий оптический диапазон. Датчик неинвазивно исследует под кожей для анализа крови, межклеточных жидкостей и различных слоев кожи на предмет определенных компонентов и физических явлений, из чего потом делаются выводы. Ранее такие биомаркеры можно было измерить только с помощью настольного оборудования.

Ну, звучит-то это все очень интересно, но, как обычно, нужно смотреть на то, как это все будет выглядеть на практике. А то слухи-то о подобных устройствах идут давно, но воз и ныне там.

Также теперь понятно, откуда растут уши слухов о том, что новые часы Apple смогут определять уровень глюкозы в крови. Дело в том, что Apple - крупнейший клиент Rockley Photonics и имеет с компанией соглашение об использовании их разработок в своих носимых устройствах. Да и в Rockley Photonics заявляли, что их датчики могут быть установлены в умных часах уже в следующем году, так что вполне возможно, что эта технология появится в какой-то новой модели Apple Watch (например, в Apple Watch 8).

Ну, посмотрим. Все это очень интересно.

Яндекс таки запустил сервис автоматического закадрового перевода англоязычных видео в Youtube и Vimeo.

Пользователям "Яндекс.Браузера" и в мобильных приложениях стал доступен закадровый перевод видео с английского языка. Поддерживаются как мужской, так и женский голос, сообщается в пресс-релизе "Яндекса".

Перевод происходит в несколько этапов. Сначала ИИ распознает речь, превращает ее в текст и с помощью нейросетей разбивает на предложения. Потом определяет пол говорящего, переводит предложения на русский язык и синтезирует голос. Остается совместить перевод с видеорядом. Это совсем не тривиальная задача, потому что в русском языке предложения длиннее, чем в английском. Здесь на помощь снова приходят нейросети.

Поэтому процесс перевода занимает несколько минут - для этого нужно поставить видео на паузу и подождать. Как только все будет готово, пользователю придет соответствующее уведомление.

Согласно заявлению компании, поддерживаются любые англоязычные видео на YouTube, Vimeo и других популярных платформах. Перевод доступен в "Яндекс.Браузере" для Windows, macOS, Linux и Android и в мобильном приложении для Android и iOS. (Отсюда.)

В Яндекс.Браузере при просмотре англоязычных роликов на соответствующем сервисе появляется вот такая надпись.

Если нажать на кнопку включить, то может сразу пойти автоматический перевод, а может появиться вот такая надпись, и тогда придется подождать, прежде чем перевод будет готов.

Погонял разные ролики. Вообще очень прикольно и прямо-таки впечатляет. Понятно, что лучше всего включать перевод на сольных выступлениях, ну и понятно, что там будет немало всяких огрехов (это совершенно неудивительно), но в общем и целом понять смысл того, о чем говорится - вполне можно. И это круто!

Заметно хуже, когда разговаривают несколько людей и еще друг друга перебивают, но и с таким вариантом сервис более или менее справился.

Я неоднократно читал о различных технологиях улучшения изображений и вообще за этими разработками стараюсь следить - это очень важно и будет востребовано.

Сейчас корпорация Google объявила о создании новой технологии улучшения изображения, повышающей разрешение картинки аж в 16 раз. Цитирую отсюда.

Разработчики Google представили новую технологию, благодаря которой можно значительно улучшить качество исходного изображения. Искусственный интеллект попиксельно восстанавливает даже сильно сжатую картинку, приближая её к оригиналу.

Команда Brain Team продемонстрировала два алгоритма генерации фотографий. Используя технологию SR3, предусматривающую апскейлинг с помощью повторного уточнения, нейросеть увеличивает разрешение картинки, достраивая недостающие части из гауссовского шума. Обучение этой модели построено на методах искажения изображения и последующем обратном процессе.

Вторая диффузная модель — CDM. Для её обучения специалисты использовали миллионы изображений в высоком разрешении из базы данных ImageNet. Улучшение качества картинки она производит каскадно — в несколько этапов. Так, исходник размером 32х32 пикселя улучшается до 64x64, а затем до 256x256 (в 8 раз), а оригинальное изображение с разрешением 64x64 точки обрабатывается по схожей схеме до 256x256 и 1024x1024 пикселя (масштабирование 16x).

По заверению разработчиков, новая технология превосходит по качеству восстановления фотографий такие современные методы ИИ-масштабирования, как BigGAN-deep и VQ-VAE-2.

На сегодня Google лишь продемонстрировала результаты работы алгоритмов посредством коротких анимаций, но ещё не публиковала подробностей о новой технологии. Когда компания планирует представить коммерческий вариант ИИ-апскейлера, не уточняется.

Выглядит это все очень интересно, но, как обычно, буду ждать, когда предоставят готовый инструмент, с помощью которого я смогу посмотреть, как это работает вживую.

Ну что, это круто, если все так и есть. Жду, когда появится - сравню с aptX HD, AAC и LDAC. Интересно, это вообще можно будет услышать? А то без хорошо прогретой бескислородной меди толком-то и не поймешь!

Qualcomm представила свою новую разработку — кодек aptX Lossless. По заверению компании, его использование обеспечит сторонникам Bluetooth-акустики качество аудио, сопоставимое с прослушиванием CD при классическом проводном подключении.

Представители Qualcomm подчёркивают, что при использовании гаджетов, которые получат поддержку кодека aptX Lossless, их владельцы смогут рассчитывать на значение битрейта до 1,4 Мбит/с. Поскольку пропускная способность самого Bluetooth-канала технически составляет 1 Мбит/с, компании пришлось применить специальную технологию потокового сжатия.

Впрочем, эксперты отмечают, что специально продуманные алгоритмы не приводят к ухудшению качества дорожки. Звук на входе идентичен выходному сигналу — 16 бит / 44,1 кГц (CD-качество). Новый кодек будет входить в состав технологии Snapdragon Sound, представленной в начале весны 2021 года.

Пока что ни одна из выпущенных Qualcomm мобильных платформ не поддерживает новую технологию. Ожидается, что выход на рынок первых смартфонов, совместимых со Snapdragon Sound и aptX Lossless, состоится уже в следующем году. (Отсюда.)

У замечательного Вастрика поразительно интересная (как обычно) статья о машинном переводе: о том, как это все начиналось, как развивалось, что с этим происходит сейчас, какие в этой области существуют прорывы и в чем заключаются проблемы. Кого интересует эта тема - очень рекомендую почитать: Вастрик, как обычно, прочитал кучу различных материалов, чтобы потом изложить все последовательно и понятно. Плюс - он реально хорошо и остроумно пишет, так что читать его - одно удовольствие. Цитировать ничего не буду, там просто нужно читать.

Кстати, должен заметить, что с появлением искусственного интеллекта машинный перевод стал заметно более продвинутым и видно, что это все активно развивается. Если раньше на перевод чего-то чуть более сложного, чем самая простейшая фраза, без слез смотреть было невозможно, то сейчас уже уровень машинного перевода заметно повысился. И машинные переводчики стали неплохо справляться даже со всякими непростыми временами, насколько я могу судить.

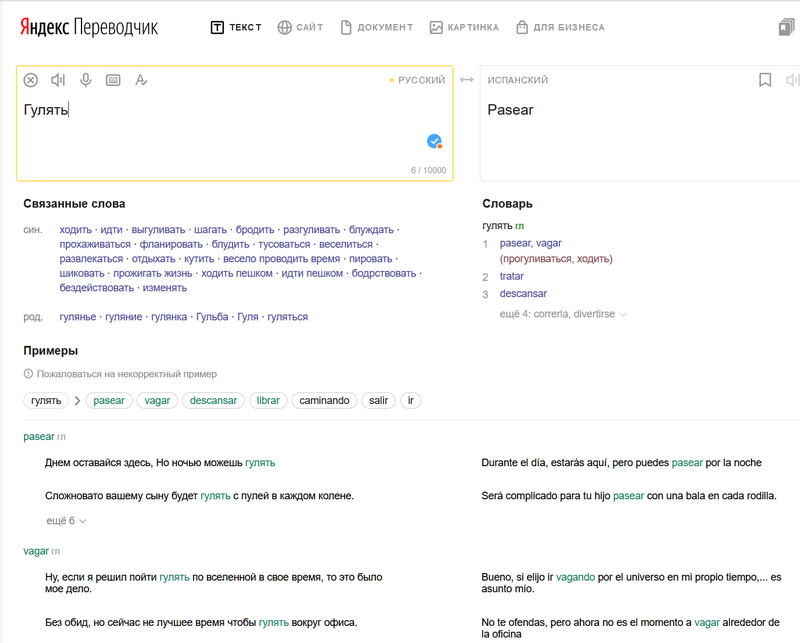

Кстати, что интересно, в моем личном рейтинг Яндекс.Переводчик обгоняет переводчик Google. Да-да, я много раз их сравнивал, и теперь пользуюсь практически только Яндекс.Переводчиком: он, на мой взгляд, более удобный и продвинутый. И дело не только в том, что ЯП определяет язык, на котором ты пишешь и автоматически меняет направление перевода, если это требуется. (Пример. В ЯП выставлен перевод с испанского на русский. Я в испанском разделе начинаю писать на русском - ЯП сам меняет направление перевода и правильно выдает результат.) А переводчик Google такое не умеет делать в упор.

Но у Яндекса также значительно разнообразнее связанные слова и намного разнообразнее реальные примеры употребления, что мне очень помогает.

Вот, сравните.

Остальные сервисы я обычно использую гугловские, особенно поиск. Но в плане автоматического перевода Яндекс тут лично у меня вырвался вперед, как ни странно.

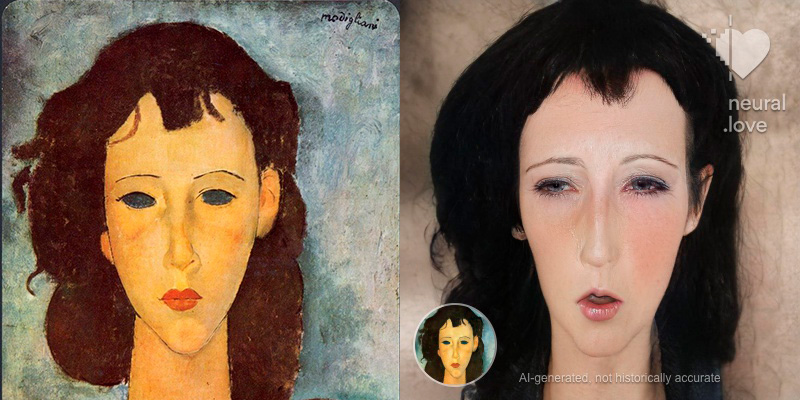

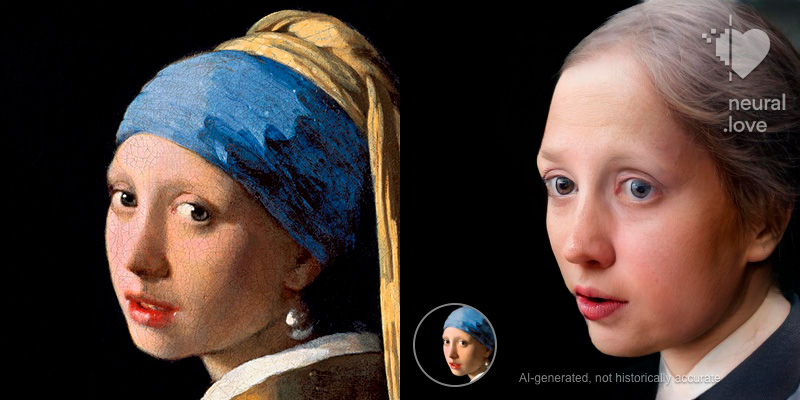

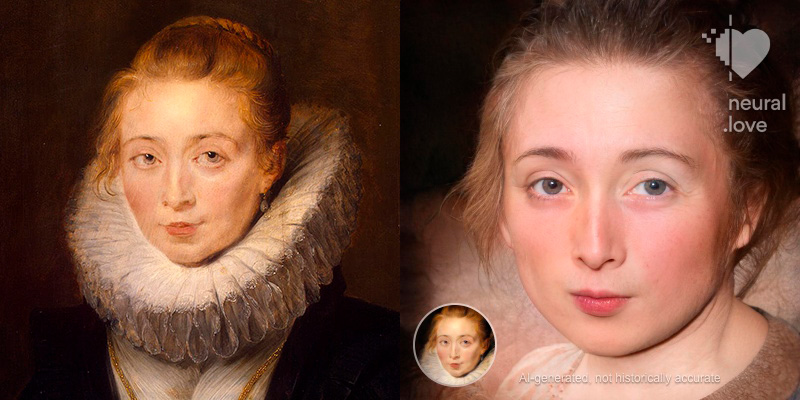

Сервис называется Neural.love. Нейросеть умеет обрабатывать фото и видео, делая реалистичными (как бы фото) рисунки и картинки. Также умеет раскрашивать черно-белые фото, но это не так интересно.

Вот пример фото.

Портреты и картинки - значительно интереснее.

Компания готовится к запуску функции отслеживания снимков в галереях смартфонов на предмет наличия незаконного контента. Сканирование будет проводиться непосредственно на iPhone, но в случае обнаружения подозрительных изображений нейросеть сообщит об этом в Apple. Информацию о нововведении, опубликованную изданием Financial Times, уже подтвердили представители бренда.

По заявлению Apple, фирменный алгоритм neuralMatch позволяет локально сканировать фотографии владельцев iPhone без их отправки на облачные сервера. «Подозрительность» снимков выявляется путём сопоставления с базой данных Национального центра поиска пропавших и эксплуатируемых детей в США, включающей более 200 000 изображений.

С помощью алгоритмов хеширования система пометит сомнительные фото — и если количество отметок достигнет определённой цифры, neuralMatch предупредит Apple о возможном обнаружении незаконного контента. После этого сотрудники компании примут решение об обращении в правоохранительные органы. Схожую систему проверки изображений под названием PhotoDNA уже применяют и другие крупные компании, такие как Facebook, Twitter и Google.

Кроме того, в iOS 15 приложение «Сообщения» будет использовать машинное обучение на устройстве, чтобы предупреждать пользователя, если он намерен отправить конфиденциальный контент. Если гаджетом пользуется ребёнок, его родители также получат оповещение об отправке подозрительных файлов с устройства. При этом, как утверждает Apple, частные сообщения будут нечитаемыми для компании. Вендор сообщил, что система вскоре будет развёрнута в США, но не уточнил, будет ли она запущена глобально и когда это произойдет.

Комментируя нововведение, профессор Университета Джона Хопкинса и криптограф Мэтью Грин отметил, что опасается попадания инструмента в руки мошенников, а сам алгоритм хеширования не исключает генерации ложных результатов. Представители бренда на заявление специалиста не ответили.

Upd: компания подтвердила, что не сможет сканировать изображения на устройствах пользователей, отключивших функцию «Фото iCloud», поскольку отметки о сомнительном содержимом прикрепляются к копиям фотографий в облачном хранилище, а не к оригинальным изображениям. (Отсюда.)

М-да. Рыться в фотографиях пользователя непосредственно на его смартфоне, помечать "подозрительные", а информацию об этих "подозрительных" еще и сливать правоохранительным органам - это, конечно, красиво. Особенно когда знаешь, насколько "эффективно" работают все эти механизмы распознавания и искусственного интеллекта.

Что-то становится все как-то грустнее и грустнее. Нет, есть, конечно, способы этому противостоять, но тенденции как-то совсем не радуют.